近日,特斯联针对大语言模型(LLM)在多层云边网络中的部署挑战,以及传统调度方法的不足,提出了一种两阶段的多层多节点LLM调度算法。该研究成果由特斯联首席科学家、香港科技大学(广州)信息枢纽物联网学域教授,杨旸博士及其课题组发布,目前已被通信领域权威国际会议INFOCOM (CCF-A) 收录。实验结果表明,该解决方案的吞吐量较传统调度方法提高9.1%-26.3%,能够在多层网络中实现LLM的高效部署,并显著提高系统性能。

原文摘录:

大语言模型(LLM)因其在理解和响应指令方面的高级能力而受到越来越多的关注。尽管在多层云边架构中得到了广泛部署,但其性能受到网络容量的严重限制,如何调度高效的数据流以实现性能最大化带来了巨大的挑战。

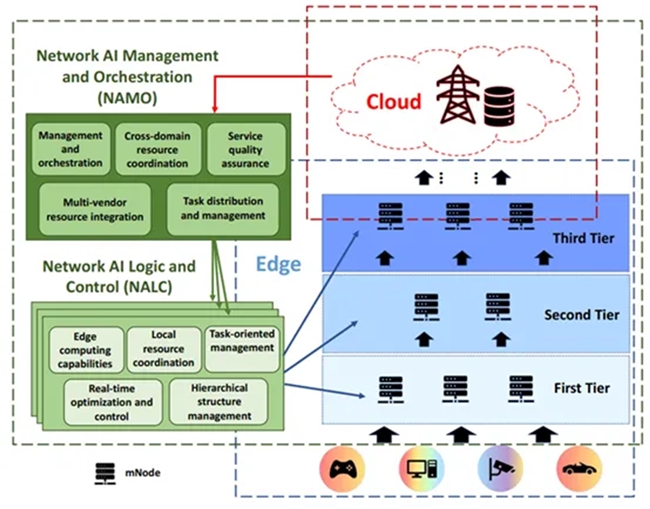

面对日益增长的AI计算需求,以及LLM在资源受限环境(如物联网和边缘网络)中的部署挑战,及时有效的任务拆分和调度变得尤为关键。这有助于充分释放LLM的潜力,并确保在多层网络中高效的资源利用。然而,多层网络的复杂性和LLM的计算密集性也给任务调度带来了巨大挑战。

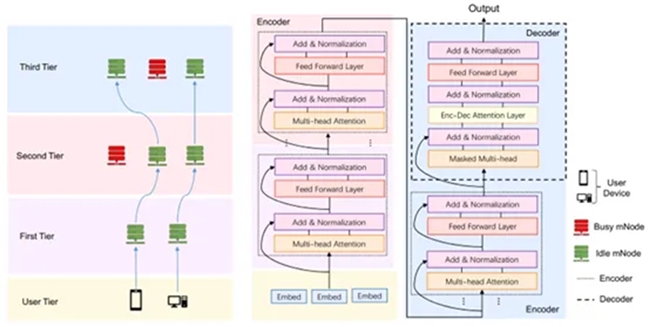

针对该挑战,杨旸博士及其课题组提出了一种两阶段的多层多节点LLM调度算法,用于协同AI计算。该算法通过两阶段的调度框架,优化了多层云边网络中的LLM推理。首先,层间LLM自动解耦和分割阶段采用整数线性规划来有效地分配模型大小和计算需求。随后,层内LLM任务调度算法利用图神经网络(GNN)评估资源利用率和网络条件,从而确定每个层内的最佳调度节点。实验结果表明,该解决方案的吞吐量比传统调度方法提高了9.1%-26.3%。依托此调度算法,该研究能够在多层网络中实现LLM的高效部署,并显著提高系统性能。

用于优化人工智能(AI)和大语言模型(LLM)部署的综合多层网络框架,该框架旨在通过分布式计算来满足现代AI应用的需求,尤其是由LLM驱动的应用。

基于Transformer的大语言模型(LLM)在多层计算环境中的分布式部署架构,旨在通过并行处理优化边缘计算中的效率和性能。核心思想是将LLM模型分割并在不同网络节点上并行处理,以降低延迟和提高计算效率。

随着大语言模型(LLM)规模的不断扩大,单节点计算已无法满足大部分LLM的需求,分布式计算成为必然趋势。该研究提出的多层级多节点调度框架为高效利用分布式资源提供了理论基础和技术支持,并通过动态资源管理和智能调度策略,有效解决了资源利用率低、通信开销大的问题,为更大规模、更复杂的AI模型部署和更低时延的协作式AI计算奠定了基础。

论文标题:Multi-Tier Multi-Node Scheduling of LLM for Collaborative AI Computing炒股资金怎么分配。